Ny leteteknologi og nye arbeidsprosesser

Olje- og gassforekomstene blir stadig vanskeligere å finne. Teknologiutvikling har gitt bedre data og bedre verktøy som har bidratt til økt forståelse av geologien og gjort det mulig å identifisere nye letekonsepter.

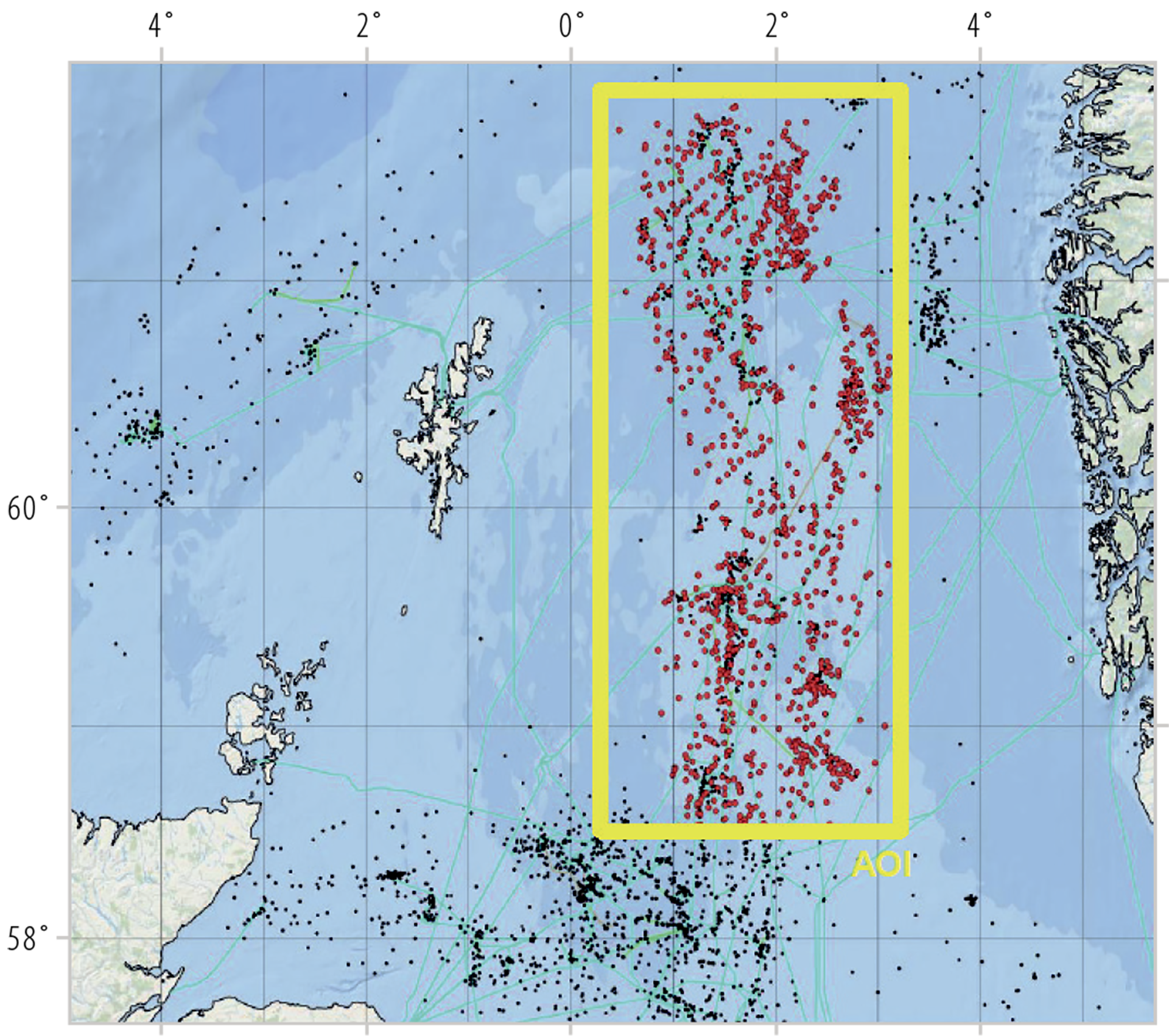

Dette kan bidra til redusert leterisiko og flere funn. Industrien må utnytte mulighetene som ligger i integrasjon av geofaglig kompetanse og digital teknologi for å identifisere nye ressurser. Figur 6.1

Teknologiutvikling, bedre kartlegging, mer data og økt forståelse av geologien kan bidra til å redusere leterisikoen og til at det gjøres flere funn. I tillegg kan teknologiutvikling gjøre det billigere å lete etter olje og gass, og dermed gjøre flere og mindre prospekt interessante å lete på. Begge disse forholdene kan bidra til at ressursbasen økes.

Grunnlaget for å finne og utvikle olje- og gassressurser legges gjennom det faglige undergrunnsarbeidet, hovedsakelig innenfor geofag. Det foregår en kontinuerlig utvikling av fagfeltet, supplert med ny teknologi og nye arbeidsprosesser.

Figur 6.1 gir en oversikt over data som samles inn, genereres eller evalueres for at det skal kunne tas kunnskapsbaserte letebeslutninger.

Figur 6.1

Illustrasjon av leteprosessen (basert på Milkov11, 2015)

11 Milkov, A V (2015): Risk tables for less biased and more consistent estimation of probability of geological success (PoS) for segments with conventional oil and gas prospective resources. Earth-Science Reviews, vol. 150, pp. 453–476.

Leting omfatter blant annet å forstå hvor og hvordan olje og gass dannes, migrerer, fanges opp i feller og bevares i reservoarbergartene i undergrunnen. For å få til gode letebeslutninger som resulterer i funn, er det nødvendig med teknologi og geofysiske målemetoder som gir god avbildning av undergrunnen. Til dette er innsamling av seismikk avgjørende, mens elektromagnetiske metoder og annen teknologi kan være verdifulle supplement.

Videreutvikling av teknologi for seismisk datainnsamling og databehandling har resultert i en markant forbedring av avbildningen av undergrunnen de siste årene. Dette har, sammen med utviklingen i geovitenskapen, gjort geologene og geofysikerne i stand til å utarbeide bedre modeller av undergrunnen og slik identifisere nye letemuligheter. Dette kan stimulere til økt leteaktivitet og resultere i flere funn.

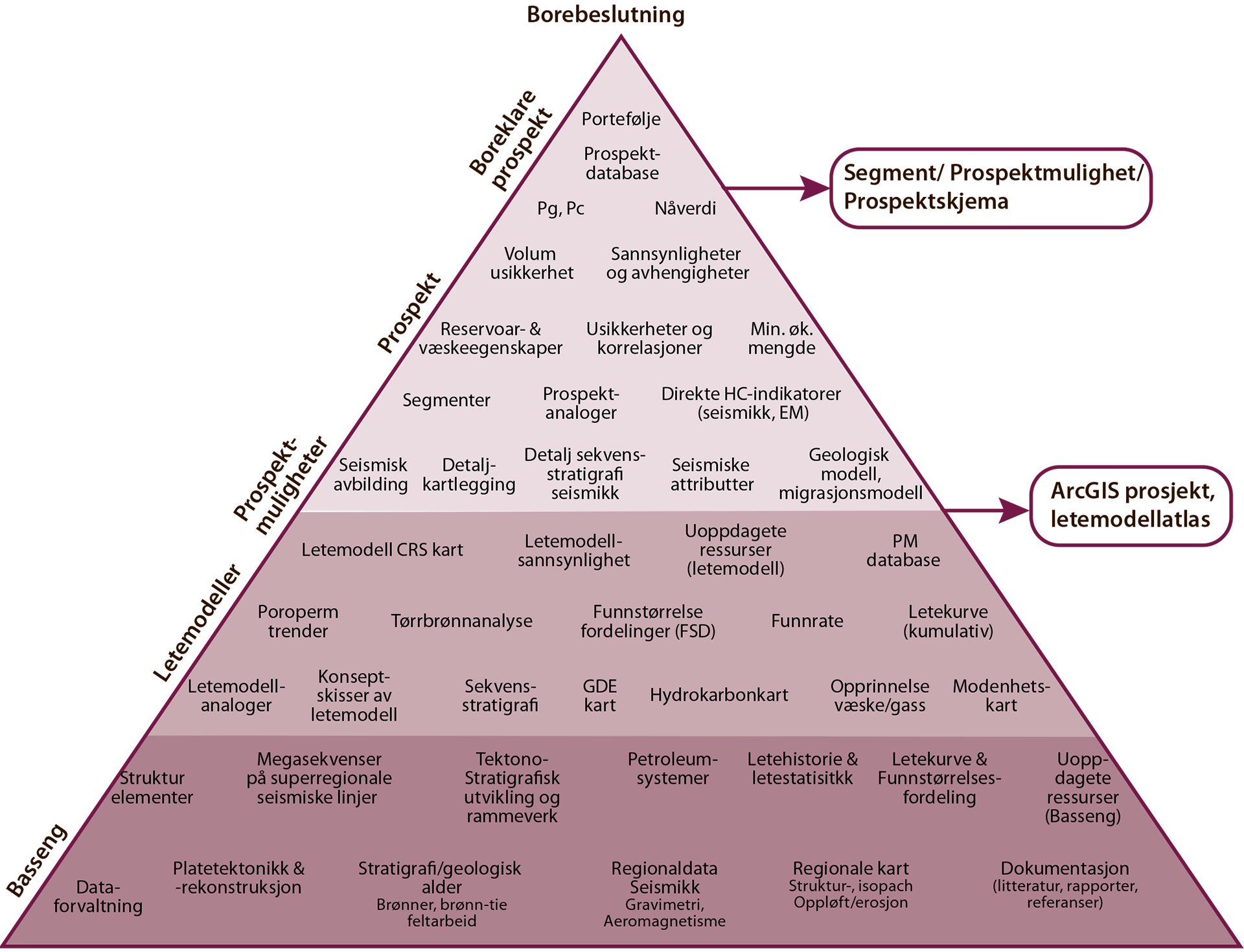

Utviklingen i teknisk funnrate viser at letevirksomheten blir stadig mer effektiv (figur 6.2). Funnraten har holdt seg på et høyt nivå siden tidlig på 1990-tallet. Ettersom funnstørrelsen avtar, er det en tendens til at gapet mellom teknisk og kommersiell funnrate øker.

Figur 6.2

Utvikling i teknisk og kommersiell funnrate (gjennomsnitt i femårsperioder)

For å bedre forståelsen av hvordan utviklingen innenfor leteteknologi og geologiske metoder har bidratt til effektiv leting, har OD gjennomført en undersøkelse i samarbeid med konsulentselskapet Westwood Global Energy Group. I undersøkelsen ble det identifisert flere viktige områder innenfor et utvidet leteteknologibegrep, som datainnsamling, geovitenskap og arbeidsmetoder. Disse har vært og vil fortsatt være viktige for letevirksomheten på norsk sokkel. OD har gruppert disse i seks hovedområder; (1) seismisk innsamling, avbildning og analyse, (2) elektromagnetiske metoder, (3) bassengmodellering, (4) boreteknologi, (5) den menneskelige faktor og (6) visualisering, stordata og maskinlæring.

SEISMISK INNSAMLING, AVBILDNING OG ANALYSE

SEISMISK INNSAMLING

Seismiske data (faktaboks 6.1) benyttes til å kartlegge geologiske forhold under havbunnen og er grunnleggende for å utforske mulighetene for å finne petroleum. De aller fleste beslutninger om leteboringer er i dag basert på 3D-seismikk.

FAKTABOKS 6.1:

|

|

Seismiske (geofysiske) undersøkelser: Innsamling av seismiske data skjer ved at lydbølger sendes fra en kilde fem-ti meter under havoverflaten. Lydbølgene forplanter seg gjennom bergartslagene og reflekteres opp til sensorer like under havoverflaten, på havbunnen, eller nede i et borehull. Dataene blir deretter prosessert, noe som gjør det mulig å danne seg et bilde av geologien i undergrunnen. Den seismiske kartleggingen av norsk kontinentalsokkel startet i 1962. Ulike typer seismiske undersøkelser:2D-seismikk samles inn med én lyttekabel. Dette gir en todimensjonal seismisk linje/tverrsnitt av undergrunnen. 3D-seismikk samles inn ved hjelp av flere parallelle lyttekabler. Dette gir et tredimensjonalt og detaljert bilde av undergrunnen. Bredbåndseismikk er en teknologi som gir et bredere spektrum av frekvenser enn konvensjonell seismikk. Det er spesielt de svært lave frekvensene som framhever strukturer mye bedre. Bredbåndmetodikken i forbindelse med seismisk prosessering kan gi mer detaljert seismikk med skarpere oppløsning og en bedre avbildning av undergrunnen. |

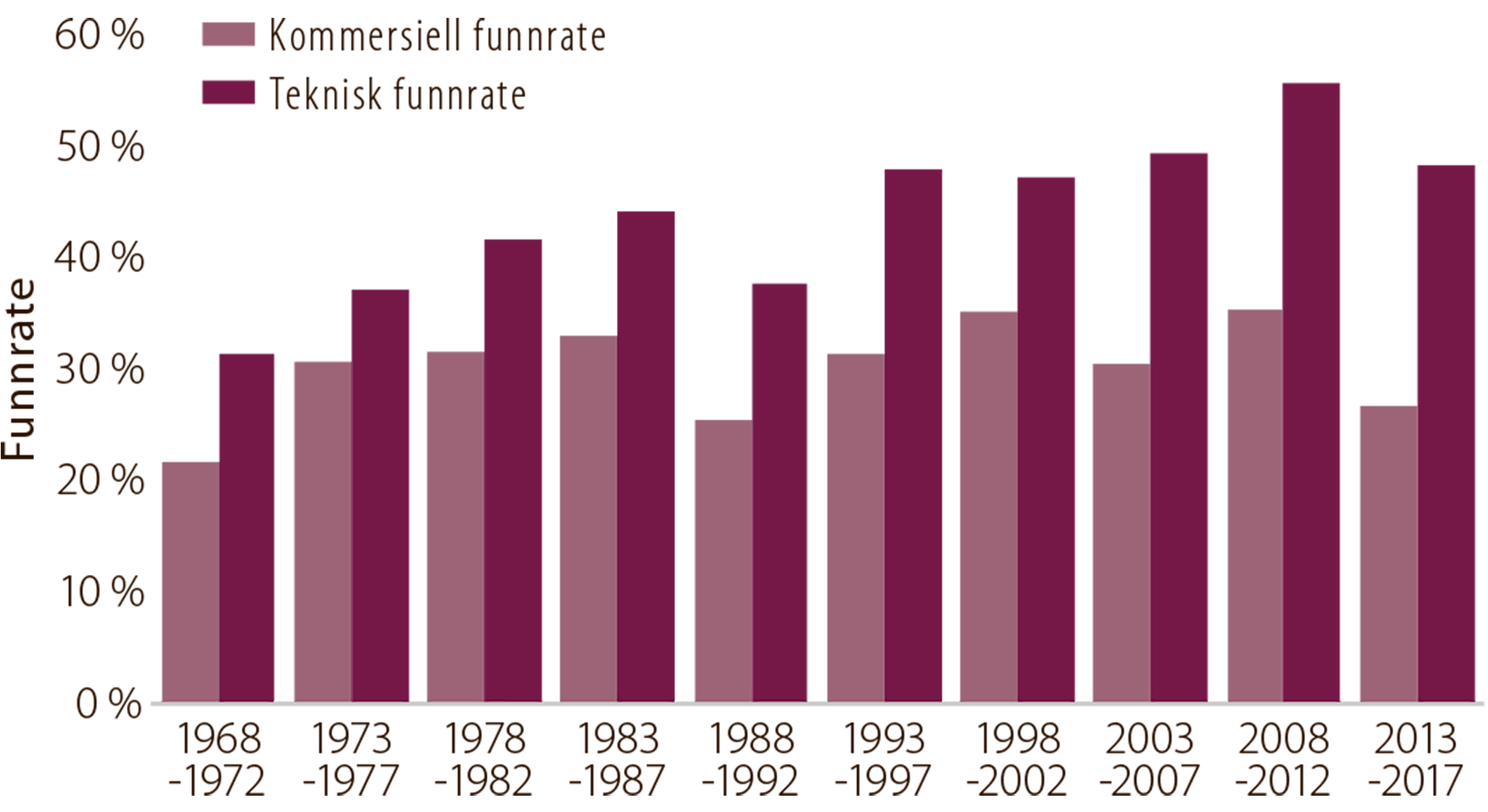

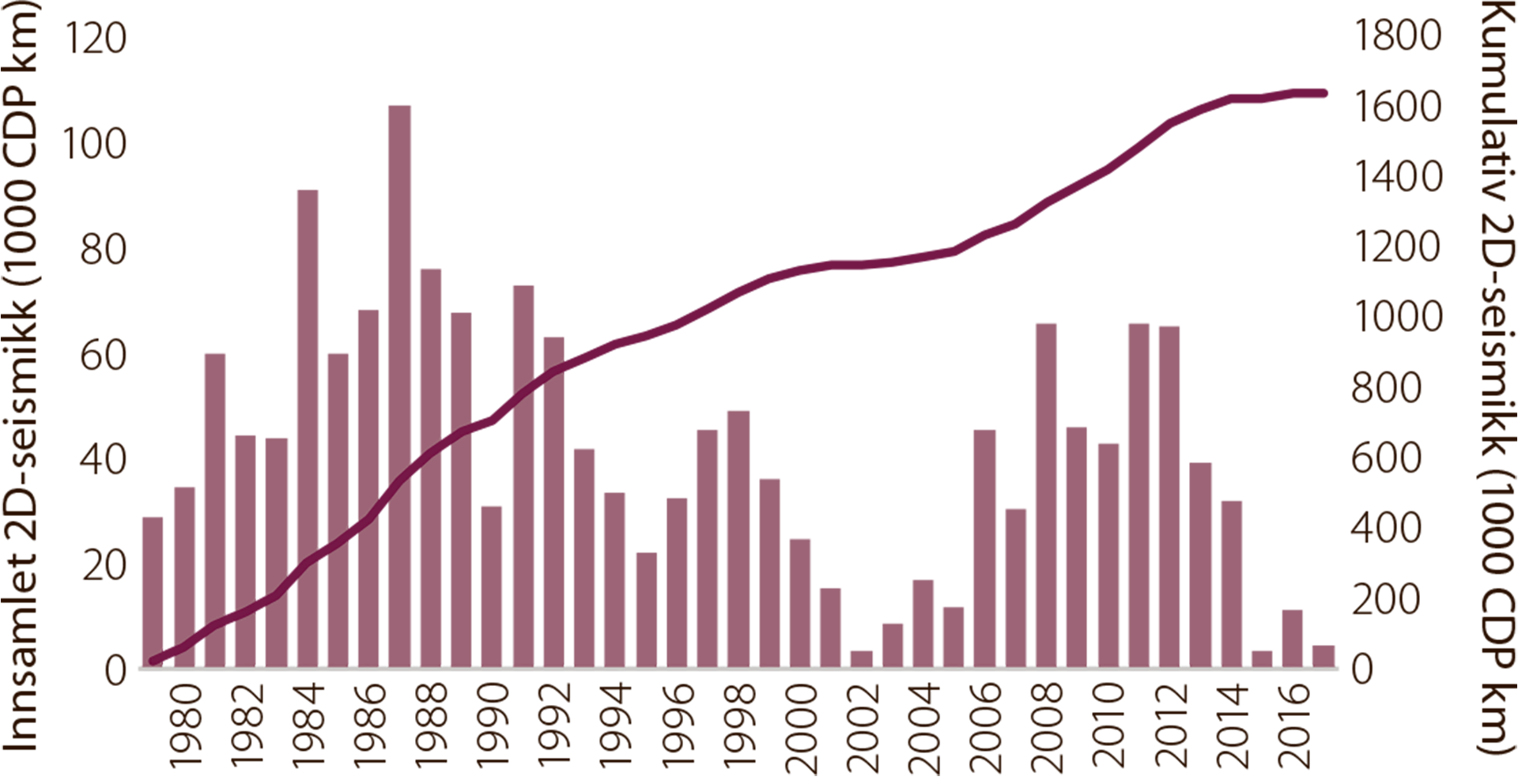

Ved utgangen av 2016 var det samlet inn til sammen 1.600.000 CDP km (Common Depth Point) 2D-seismikk på norsk sokkel (figur 6.3). De siste årene er innsamling av 2D-seismikk betydelig redusert.

Figur 6.3

Innsamling av 2D-seismikk på norsk sokkel

De første kommersielle 3D-seismiske undersøkelsene på norsk sokkel ble gjennomført på slutten av 1970-tallet. Den første undersøkelsesbrønnen som ble boret på grunnlag av innsamlet 3D-seismikk, var funnbrønnen 30/6-17 ved Oseberg-feltet i 1985.

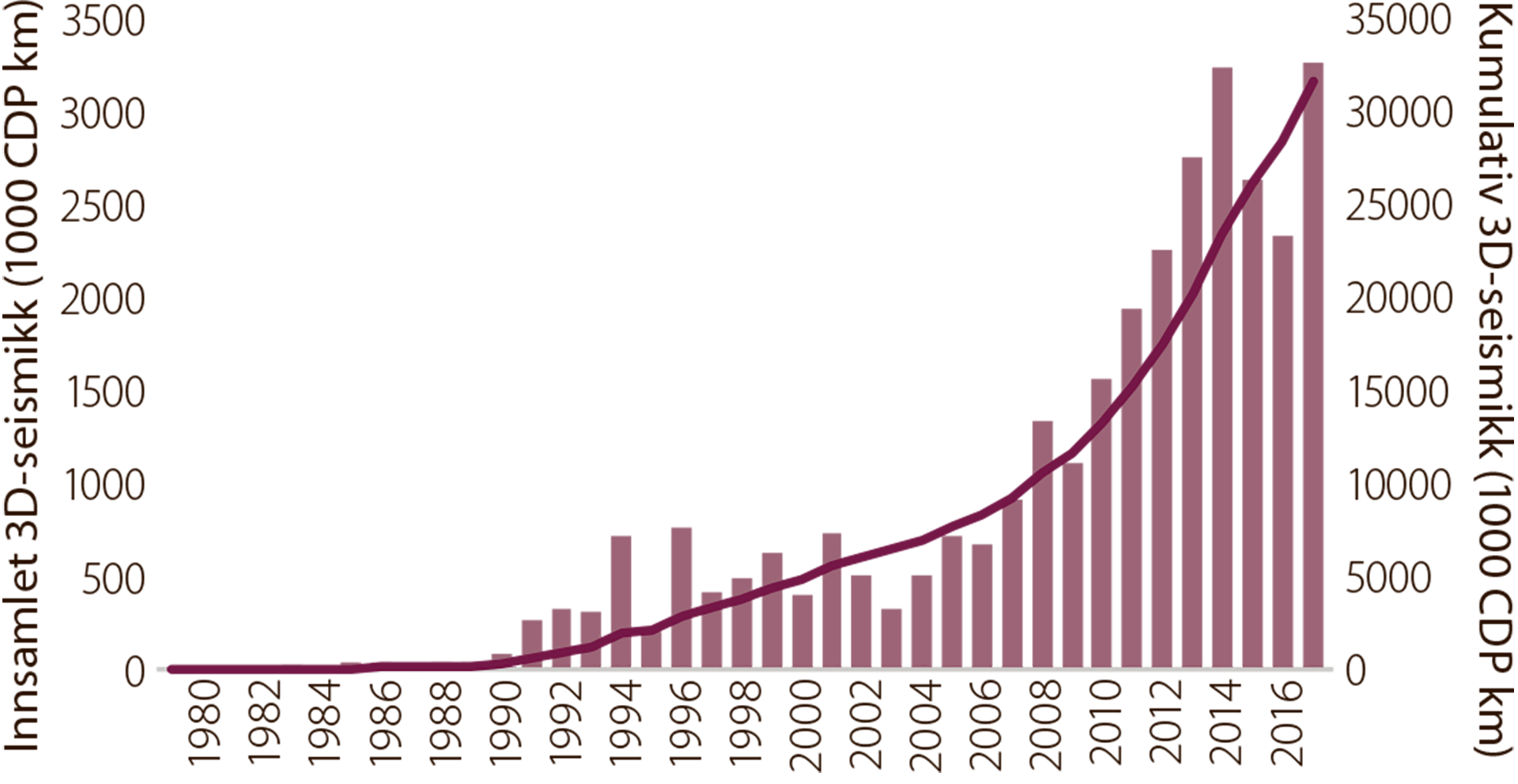

Omfanget av innsamlet 3D-seismikk varierte lite mellom 1994 og 2006, men økte betydelig fra rundt 2007-2008 og fram til 2014 (figur 6.4).

Figur 6.4

Innsamling av 3D-seismikk på norsk sokkel

BEDRE AVBILDNING

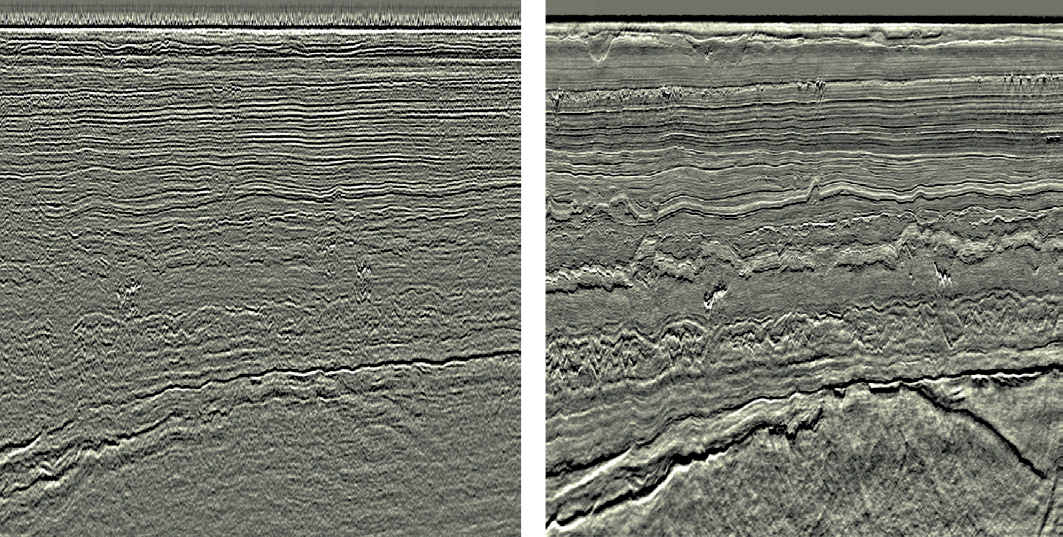

Den seismiske datakvaliteten er gradvis forbedret de siste årene (figur 6.5). Forbedringene har skjedd innenfor både innsamlingsmetodikk og dataprosessering. Det største teknologispranget på 2000-tallet er utvikling og implementering av bredbåndseismikk (faktaboks 6.1). I tillegg har det vært betydelige forbedringer av prosesseringsalgoritmene, spesielt innenfor tredimensjonal migrasjon. Dette har gjort avbildningen skarpere og posisjoneringen mer nøyaktig, spesielt i områder med kompleks geologi.

Figur 6.5

Eksempel på forbedring av seismisk datakvalitet fra 2007 (til venstre) til 2013 (til høyre). Eksempelet er fra Edvard Grieg-feltet. (Illustrasjon: WesternGeco).

Store deler av sokkelen, spesielt de modne områdene i Nordsjøen og Norskehavet, er dekket av bredbånd 3D-seismikk de siste årene. Kombinert med økt datakraft og nye tolknings- og visualiseringsverktøy har dette gjort det mulig å identifisere nye letemuligheter, også i arealer som er utforsket tidligere.

En stor del av disse letemulighetene ligger nær eksisterende infrastruktur og kan representere betydelige verdier gjennom rask innfasing. Ressurser rundt dagens felt må finnes mens det fortsatt er infrastruktur tilstede. Ny seismikk og nye innfallsvinkler kan også gi de gamle feltene flere leveår og legge grunnlag for beslutning om utbygging av brakke funn.

Anvendelse av bredbåndsteknologi vil trolig øke i omfang. Utviklingen av algoritmer innen prosessering av seismiske data forventes å fortsette, og gjør det mulig for industrien å oppnå bedre resultater ved å reprosessere eksisterende datasett.

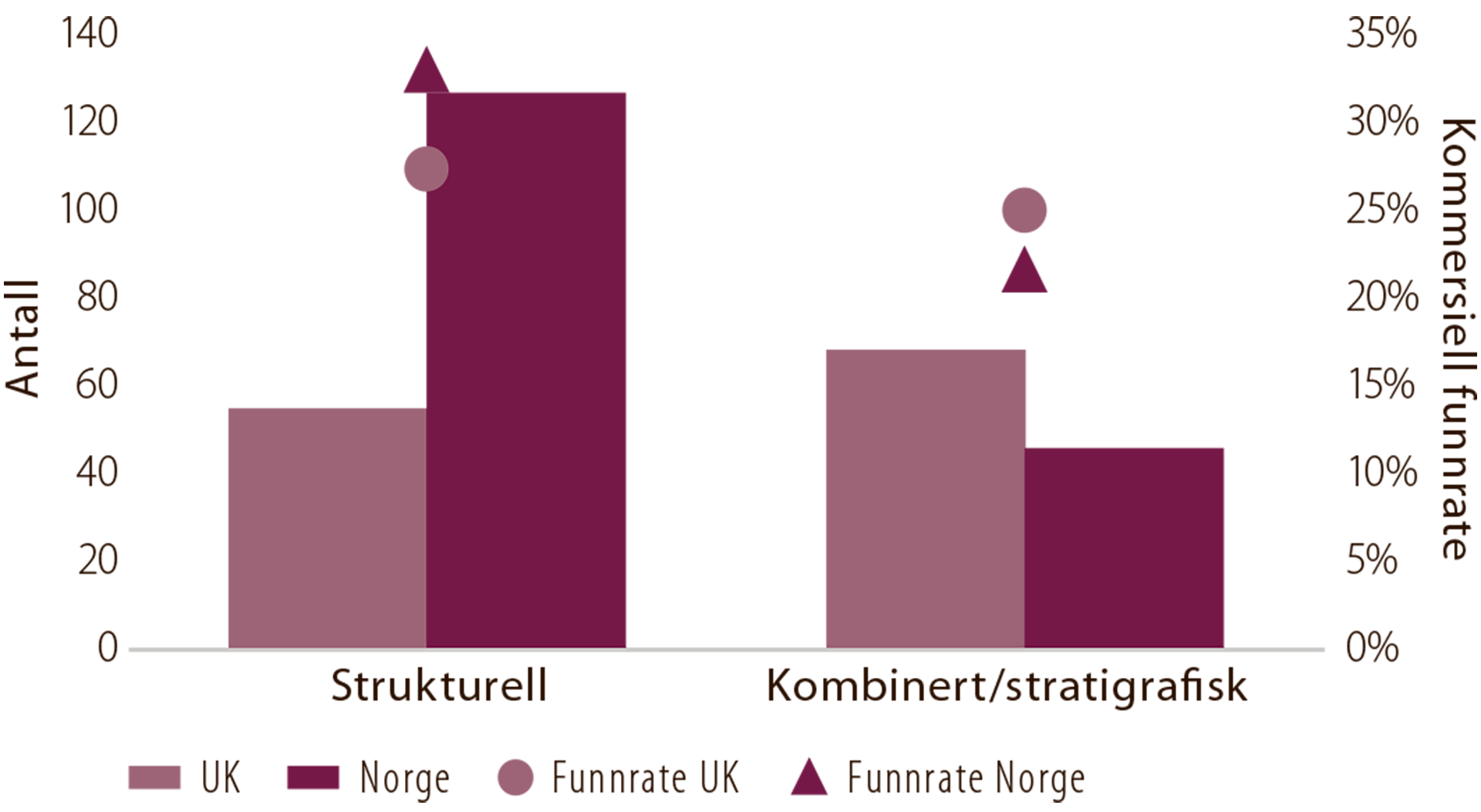

Bedre seismisk avbildning kombinert med forbedret seismisk dataanalyse kan også bidra til å identifisere flere stratigrafiske feller. Interessen har vært stor for injektitter som er en spesiell form for stratigrafisk felle. Eksempler på slike feller er funnene 24/9-5 (Volund), 25/4-10 S (Viper) og 25/7-5 (Kobra). Prospekt med stratigrafiske felletyper har vært mindre utforsket på norsk sokkel enn på britisk sokkel som er mer moden (figur 6.6). Det har også vært høyere funnrate for denne typen prospekt på britisk sokkel. Det kan indikere at det er et potensial på norsk sokkel som enda ikke er realisert og erfaringsoverføring mellom britisk og norsk sokkel kan bli viktig.

Figur 6.6

Felletyper og kommersielle funnrater i Norge og UK, 2008-2017

(kilde: Westwood)

SEISMISK DATAANALYSE

Siden 1990 har økt omfang av innsamlet seismikk og bedring i den seismiske datakvaliteten bidratt til utvikling av nye og bedre analyseverktøy.

Dette har resultert i store framskritt innenfor kvantitativ seismisk dataanalyse. I tillegg har økt datakraft gjort beregningene betydelig raskere og mer detaljerte. Dette har åpnet for mer avanserte seismiske analyseteknikker, spesielt innen AVO og Inversjon.

I følge Westwood ser det ut til at industrien ikke utnytter alle mulighetene som ligger i å integrere seismiske dataanalyser med geologisk kunnskap og erfaring. Metodene må bli bedre integrert i den geologiske evalueringsprosessen (figur 6.1).

Mer integrering betyr at mennesker med ulik faglig spesialisering må samarbeide på nye måter og mye tettere enn før. Teknologien og metodene er nyttige og avanserte verktøy. Kombineres teknologien med geologisk erfaring og kunnskap, øker sannsynligheten for å gjøre de store funnene.

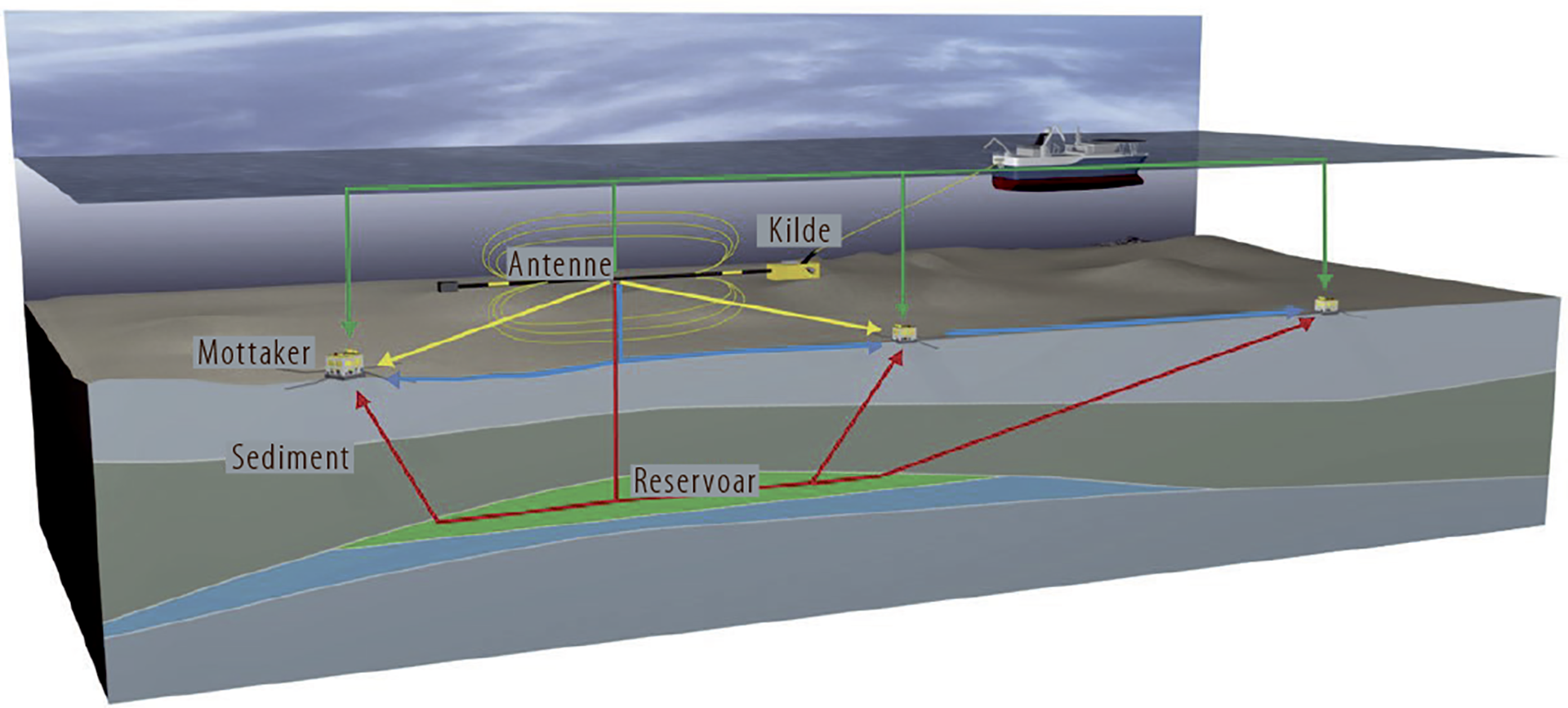

ELEKTROMAGNETISKE METODER

Elektromagnetiske metoder (CSEM – kontrollert kilde elektromagnetisk metode) ble introdusert og kommersialisert tidlig på 2000-tallet. Denne metoden gjør det mulig å måle elektrisk motstand i bergartene og sammenlikne det med målinger i borehull. Høy elektrisk motstand kan blant annet gi indikasjoner på om det er hydrokarboner tilstede. Utfordringen er at i en rekke områder er det andre elementer i undergrunnen som kan gi tilsvarende respons. For eksempel har salt og bergarter med mye organisk materiale høy motstand og kan gi «falsk» respons. Treffsikkerheten til denne målemetoden er derfor noe variabel, og det kan være avgjørende å ha god kalibrering mot eksisterende felt og funn for å forbedre metoden (figur 6.7).

Figur 6.7

Elektromagnetiske metoder

(illustrasjon: EMGS)

Siden introduksjonen tidlig på 2000-tallet har tidvis manglende treffsikkerhet gjort at deler av industrien er skeptisk til nytten av elektromagnetiske metoder (EM). EM-data har vist seg å ha god treffsikkerhet i deler av Barentshavet, spesielt der reservoarene ligger grunt. Funnet 7324/8-1 (Wisting) ligger svært grunt, om lag 250 meter under havbunnen, og er ideelt for å måle elektromagnetisk respons. I dette området har bruk av EM-data vært nyttig. I løpet av de siste årene er teknologien videreutviklet med bruk av 3D-innsamling, forbedrede inversjonsteknikker og kraftigere kilder som kan nå dypere reservoarer. Det forventes mer bruk av CSEM både på norsk sokkel og internasjonalt.

BASSENGMODELLERING

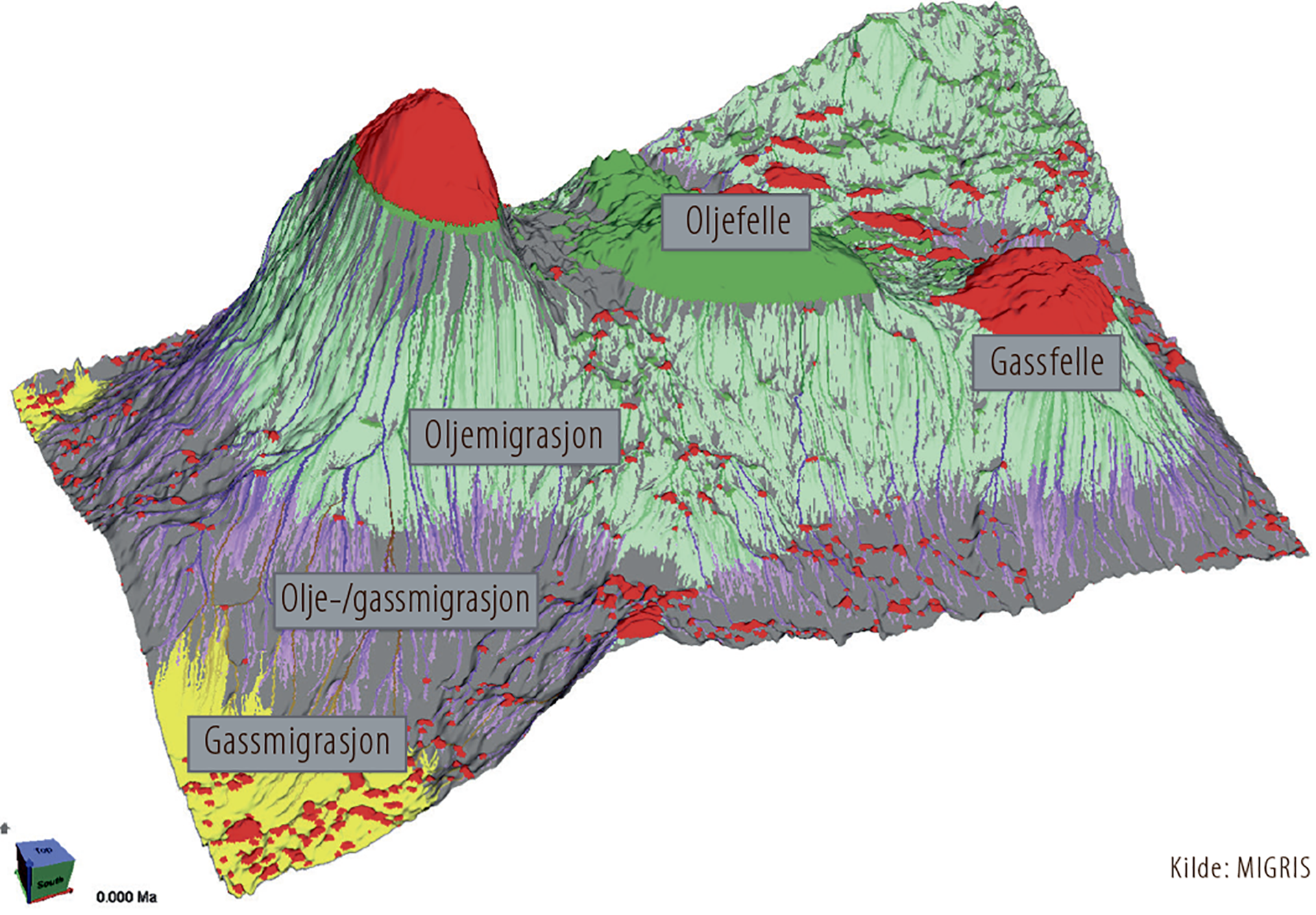

Det har vært betydelig økning i beregningskapasitet for tredimensjonal bassengmodellering (figur 6.8).

Figur 6.8

Visualisering av 3D bassengmodellering

Evnen til å måle geokjemiske parametere har vist betydelige framskritt. Dette gjelder gassanalyser under boring, mer detaljert måling av biomarkører og gjennomføring av kerogenanalyser ved hjelp av skanning- elektronmikroskop (SEM).

Økt datakraft og store datamengder vil trolig bidra til å utvikle og forbedre mulighetene som ligger i 3D-bassengmodellering. Innenfor geokjemi vil nye måter å analysere gass i boreslam bli viktig for å forstå migrasjonen av hydrokarboner bedre.

Økt tilgang på seismiske data av høy kvalitet fra enkelte bassenger andre steder i verden har ført til bedre forståelse av sedimentære systemer i undergrunnen. Denne forståelsen og kunnskapen brukes på norsk sokkel, særlig i forbindelse med letemodeller i dypvannsområdene.

BORETEKNOLOGI

Utviklingen innenfor boreteknologi har medført at verken vanndyp eller trykk er til hinder for å kunne bore sikre letebrønner.

I andre deler av verden bores det nå letebrønner på vanndyp opp mot 4000 meter. Den brønnen som er boret på dypest vann på norsk sokkel er undersøkelsesbrønn 6403/6-1 i Norskehavet. Den ble boret i 2006 av Statoil på 1721 meter vanndyp med boreriggen Eirik Raude.

Dagens boreteknologi og utblåsningsventiler (blowout preventer, BOP) gjør det mulig å bore høyt trykk og høy temperatur (HTHT)-brønner12 med trykk på opptil 1050 bar.

12 Brønner med trykk over 690 bar og/eller bunnhullstemperatur over 150 grader Celsius

En annen boreteknologi, høyavviksboring, er nå standard praksis i feltutvikling, og gjør det mulig å undersøke letemål fra eksisterende infrastruktur og knytte opp eventuelle funn for rask produksjon.

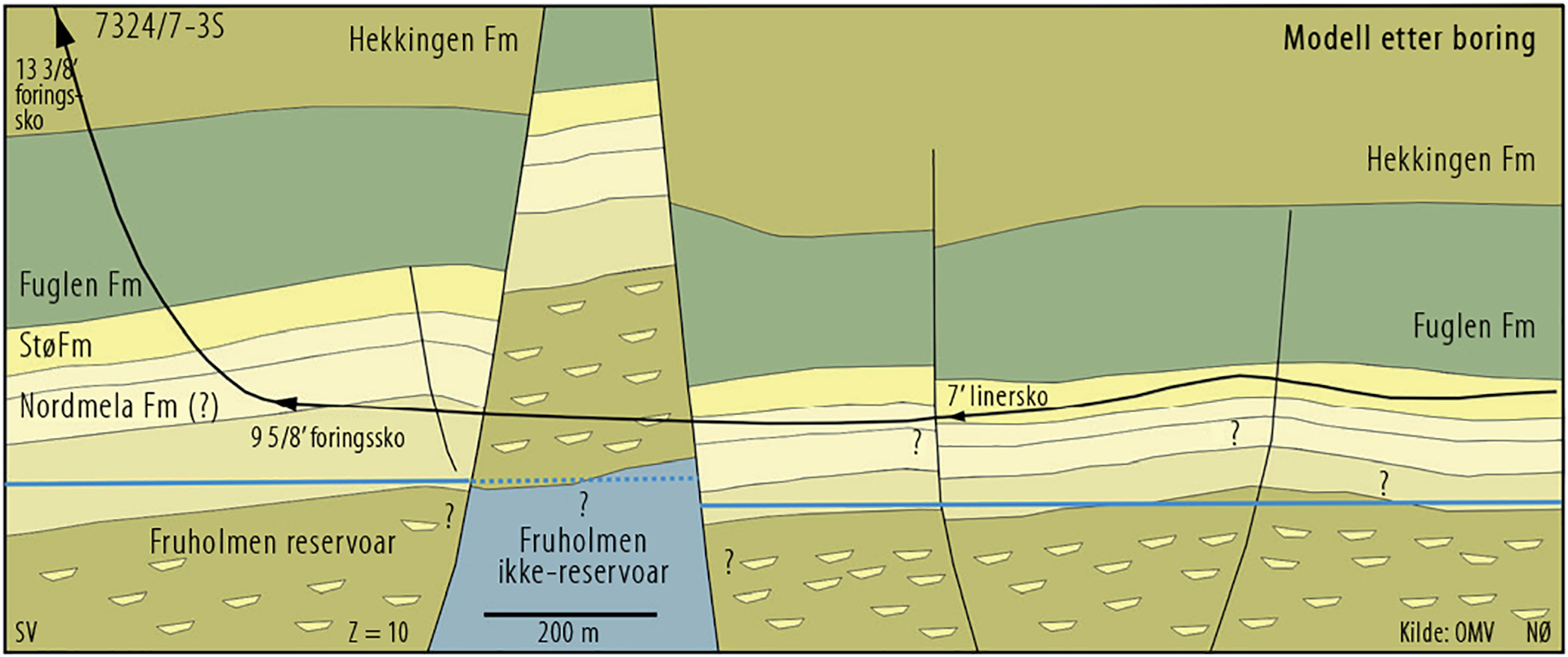

De siste årene er det gjort flere funn så grunt som om lag 200 meter under havbunnen. Det mest kjente eksempelet er 7324/8-1 (Wisting) som ble boret 250 meter under havbunnen i Barentshavet. Før operatøren OMV utførte en vellykket høyavviksbrønn i 2017, var det tvil om det ville være mulig å basere en feltutvikling på horisontale brønner i så grunne reservoarer (figur 6.9).

Figur 6.9

Høyavviksboring på oljefunnet 7327/8-1 (Wisting) (med avgrensningsbrønn 7324/7-3 S)

DEN MENNESKELIGE FAKTOR

Studier som er gjennomført av offentlige myndigheter som OD i Norge og Oil and Gas Authority (OGA) i Storbritannia, viser at oljeselskapene overestimerer volumet i prospekt, både i sine søknader i konsesjonsrunder og ved tidspunkt for borebeslutning. I tillegg har estimatene ofte et for snevert usikkerhetsspenn.

Det er også en tendens til at selskapene undervurderer funnsannsynligheten. I sum gir dette flere, men mindre funn enn prognosert. Mange oljeselskap har gjort studier basert på sine egne data og publisert liknende konklusjoner, ofte med utgangspunkt i globale datasett. Problemstillingen er ikke ny, og allerede i ODs ressursrapport for 1997 ble dette beskrevet (kapittel 7).

Årsaken til problemet er sammensatt, men det handler sannsynligvis mer om psykologi enn om geologisk kunnskap, metodikk, programvare og data. Problemet er heller ikke unikt for prospektevaluering. Det kan oppstå i alle situasjoner hvor mennesker tar beslutninger eller gir prognoser basert på egne vurderinger av tilgjengelig informasjon. Psykologene Daniel Kahneman og Amos Tversky skrev på 1970 og -80 tallet flere artikler om temaet. De påviste en rekke såkalte kognitive bias (skjevheter, systematiske feil) som oppstår som følge av måten mennesker vurderer informasjon. Det er seinere identifisert en rekke andre typer bias enn de som Kahneman og Tversky beskrev.

For å kunne fjerne ulike bias må de først erkjennes, og det må skapes forståelse for hvorfor og hvordan de oppstår. Mange selskap arbeider i dag systematisk med å etterprøve sine estimater mot de faktiske resultatene. De fleste har i tillegg ulike grupper for kollegastøtte (peer assist) i evalueringsfasen og kvalitetssikringsgrupper med erfarne medarbeidere som ser evalueringer på tvers av selskapet. Mange driver også systematisk opplæring i prospektevaluering, også hvordan bias i estimatene skal unngås.

Historisk har kanskje selskapene hatt større fokus på rangering av prospektene sine basert på andre kriterier enn absolutt forventningsrette estimat for volum og funnsannsynlighet. Til tross for dette har leting på norsk sokkel vært, og er fremdeles lønnsom. Etter hvert som norsk sokkel blir mer moden og funnene blir mindre, blir det imidlertid stadig viktigere at estimatene er forventningsrette, slik at det ikke blir tatt beslutning om boring av ulønnsomme prosjekter.

VISUALISERING, STORDATA OG MASKINLÆRING

De tidligste tolke- og arbeidsstasjonene for seismikk ble tilgjengelig fra midten av 1980-tallet. Disse var utviklet i forskningsinstitusjoner eller som proprietær programvare i store oljeselskap. Fra midten av 1990-tallet ble datateknologi og arbeidsstasjoner i større grad tilpasset behovet for å tolke store mengder 3D-seismiske data. Desktop 3D-visualisering av seismiske, geologiske og brønnrelaterte data ble mulig fra 1990-tallet, men ble først effektivt tidlig på 2000-tallet. Etter den tid har funksjonaliteten blitt stadig bedre.

Visualisering av undergrunnsdata via virtuelle virkelighetssystemer blir stadig utviklet, slik at for eksempel geologiske feltturer nå kan utføres i virtuell virkelighet (Virtual Reality, VR). Etter hvert blir skybaserte løsninger med tilgang fra hvor som helst i verden viktigere. Integrasjon av undergrunnsdata fra ulike disipliner er nå ofte tilgjengelig på en felles plattform.

Ordene «Big Data» eller stordata, maskinlæring og kunstig intelligens ble en del av leteindustriens vokabular rundt 2012. Undergrunnsdata fra seismikk og brønner inneholder enorme mengder informasjon der det kan tenkes at stordataanalyser kan brukes til å bringe fram ny informasjon. Industrien prøver nå å forstå hvordan dette vil kunne påvirke letevirksomheten. Mange selskap har satt i gang store digitaliseringsprosjekt. I tillegg er flere tiltak satt i gang av blant annet OD, OGA og OGTC (Oil and Gas Technology Centre). Hensikten er å forstå hvordan stordata og maskinlæring kan bidra til bedre og mer effektiv leting (faktaboks 6.2).

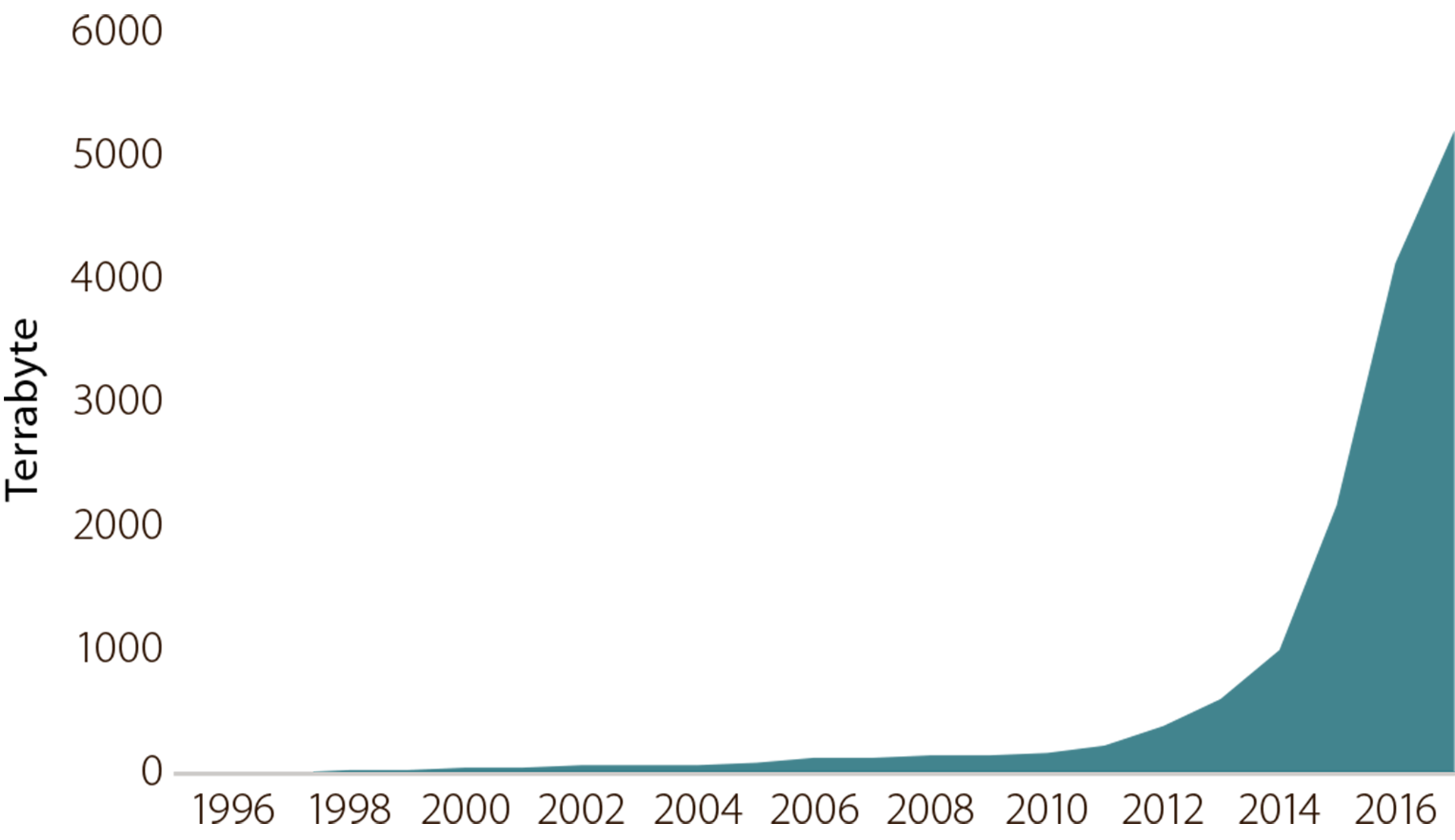

På norsk sokkel er seismikk og brønndata lett tilgjengelig gjennom Diskos, og mye av dataene er frigitt. Datamengden i Diskos har vokst eksponensielt siden 2010 (figur 6.10). Flere funn er gjort på grunn av tilgang til historiske data som er reevaluert med nye teknikker og teknologier, og ved å sammenstille data på nye måter. Det kan tenkes at stordataanalyser kan gi ny innsikt her.

I dag er mye av dataene vanskelig tilgjengelig for analyser, fordi de er lagret i ulike formater på forskjellige medier (for eksempel i form av scannede papirdokumenter). I Diskos blir det nå arbeidet med bedre tilrettelegging av data, slik at de lettere kan brukes i slike analyser.

Figur 6.10

Utviklingen i datamengde i Diskos

FAKTABOKS 6.2:

|

|

I Nordsjøen er det i over 50 år samlet inn store datamengder fra brønner. I disse dataene ligger det informasjon som kan gi nye funn. Ulempen er at dataene har ulike formater, er av variabel kvalitet og at det kan være tidkrevende å bearbeide dem slik at de kan brukes i analyser. Oil and Gas Technology Center (OGTC) i Aberdeen er overbevist om at avanserte algoritmer, som maskinlæring, kan bidra til å redusere denne utfordringen. Sammen med OGA (Oil and Gas Authority) i Storbritannia og OD startet OGTC derfor et prosjekt som er på jakt etter analysemetoder som kan levere vurderinger av strukturerte og ustrukturerte brønndata, raskt og nøyaktig. Målet er å bruke dataene til å identifisere og klassifisere intervaller som kan indikere tilstedeværelse av tidligere uoppdagede eller oversette petroleumsforekomster. Prosjektet er etablert under OGTCs Open Innovation Program og retter seg mot kommersielle organisasjoner, akademiske institusjoner, innovatører og entreprenører fra og utenfor oljeog gassindustrien som kan ha ideer om hvordan disse utfordringene kan løses. For de beste forslagene vil OD sammen med OGA og OGTC stille til disposisjon store mengder brønndata fra nordlige deler av Nordsjøen. Prosjektet vil bli gjennomført i løpet av 2018. |